В ходе эксперимента, проведенного двумя исследователями в области образования, ChatGPT было предложено решить вариант знаменитой «задачи удвоения квадрата» — математической головоломки, описанной Платоном примерно в 385 году до нашей эры. К удивлению ученых, оказалось, что, столкнувшись с 2400-летней задачей по математике, чат-бот повел себя не как искусственный интеллект, а скорее как человек.

Задача удвоения квадрата

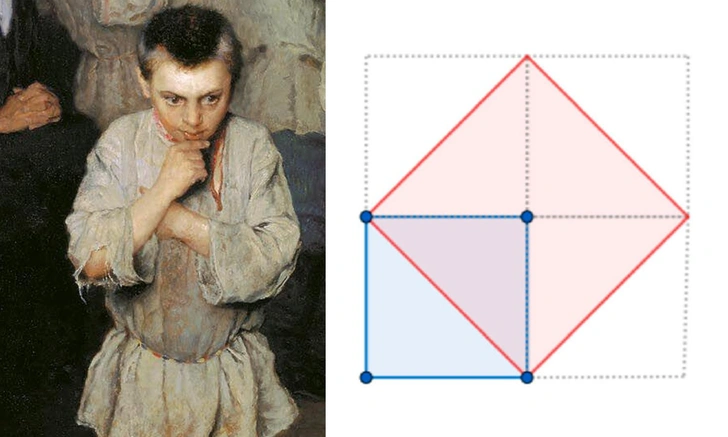

В одном из своих «Диалогов» Платон показывает, как Сократ подводит к верному решению математической задачи — удвоить площадь квадрата — неграмотного мальчика-раба. Сначала мальчик ошибочно предлагает удвоить длину каждой стороны, но, благодаря наводящим вопросам Сократа, он, в конце концов, приходит к правильному ответу: стороны нового квадрата должны быть такой же длины, как и диагональ исходного.

Эту задачу авторы статьи, в International Journal of Mathematical Education in Science and Technology, называют «возможно, самым ранним задокументированным экспериментом в области математического образования». В течение многих веков она вызывает споры о том, находятся ли знания в нас «в скрытом состоянии», ожидая, чтобы их «извлекли», или же мы «генерируем» их посредством жизненного опыта и обучения.

Надав Марко и Андреас Стилианидес из Кембриджского университета решили выяснить, как отреагирует на «задачу удвоения квадрата» ChatGPT — решит ли он ее, используя уже готовые ответы из базы данных, или же будет «думать на ходу», то есть искать собственные решения.

Ученые ожидали, что ChatGPT справится с задачей, воспользовавшись уже имеющимися знаниями о знаменитом решении Сократа. Однако вместо этого он, похоже, импровизировал и даже допускал «человеческие» ошибки.

Например, когда ChatGPT попросили удвоить квадрат, он выбрал вместо геометрического алгебраический подход, который был неизвестен во времена Платона. Мало того, ИИ активно сопротивлялся попыткам заставить его перейти к геометрии и упрямо придерживался алгебры, даже когда исследователи жаловались на неточность его ответов.

Только когда Марко и Стилианидис выразили ChatGPT свое разочарование тем, что, несмотря на всю его подготовку, он не смог дать «элегантный и точный» ответ, чат-бот согласился выдать его геометрическую альтернативу.

При этом, когда ученые напрямую спросили ChatGPT, знакомы ли ему труды Платона, тот продемонстрировал полное знание этого источника. «Если бы он просто помнил по памяти, он почти наверняка сразу же сослался бы на классическое решение — построить новый квадрат по диагонали исходного квадрата, — Стилианидис. — Но вместо этого он, похоже, выбрал свой собственный подход».

Исследователи сравнили поведение ChatGPT с поведением студента. «Когда мы сталкиваемся с новой проблемой, наш инстинкт часто подсказывает нам пробовать что-то, основываясь на нашем прошлом опыте, — пояснил Марко. — В нашем эксперименте ChatGPT, похоже, делал нечто подобное — так же, как учащийся или ученый, он, казалось, предлагал собственные гипотезы и решения».

Вы доверили бы нейросети важную задачу, например, написать курсовую или сделать презентацию для выступления на конференции?

- 10.5%Конечно, зачем тратить свое время?

- 37.9%Нет, и речи быть не может! Сочинит факты и всё напутает!

- 51.6%Попрошу нейросеть сделать, но внимательно проверю за ней факты и цифры.

Может, в математике эта модель не сильна, зато у ChatGPT отлично получается рисовать летающих котов и Сальвадора Дали.